Nach der ersten Phase der "elektrischen Musikinstrumente" (Stunde 3) und der "Experimentellen Musik" eines John Cage (Stunde 4) stand die Elektronische Musik stets im Spannungsfeld zwischen vorgefertigterr "Lautsprechermusik" und live in einem Konzert ausgeübter Elektronik. Viele Kompositionen waren "Music for Tape" (siehe die Beispiele der Stunde 5 und 6) und liefen anstandslos im Radio, machten aber Schwierigkeiten im Konzert. Es wurde von Anfang an als ein Manko empfunden, wenn eine Komposition nur von einem Lautsprecher und nicht von Menschen reproduziert bzw. wieder gegeben wurde... vor allem eben im Konzert. Elektronische Musik von "hohem Niveau", wie es die Kölner Schule gefordert hatte, von Musiker/innen aufführen zu lassen, war und ist bis heute eine interessante Herausforderung. Ich selbst habe dazu mehrere Projekte initiiert und in diesem Sektor über 70 Konzerte durchgeführt.

Vorgehen in einer 90-Minuten-Einheit: Vortrag zum DJing (25 Minuten), Einzelarbeit zu verschiedenen Ausprägungen von Live-Elektronik gemäß Blatt 10 (20 Minuten), Besprechung von Fragen (15 Minuten), Vortrag zu Oldenburger Projekten der Live-Elektronik (30 Minuten).

Die Stunde erfolgt entlang der PowerpointPrässentation Ppt 10 und Blatt 10. Einzelarbeit erfordert Aufgabenblatt 10.

Geschichte des DJing: Soundsystems in Jamaika → Bronx (N.Y.) mit Afrika Bambaataa (Plattenauflegen und dazu Sprechen/Singen auf der Staße) → Club-Culture (Chicago) → Love Parade (karnevalartiger Straßenumzug von Wagen, die ein Soundsystem enthalten) in Berlin → "Raves" (Großtanzveranstaltungen mit einstündigen Sets eines DJ's)

Analyse des Auftritts der DJ's Marc Spoon und Paul van Dyk auf der Berliner Love-Parade 1998:

Die Strategie eines DJ‘s heißt "Spannungsaufbau und Break"

Ist das "Elektronische Musik"?

Die "Instrumente" eines Live-Auftritts wurden im Laufe der 1990er und der folgenden Jahre ständig verfeinert. Drei typische Instrumente, mit deren Hilfe elektronische Sounds hergestellt oder elektronische Grooves live zusammen gestellt und bearbeitet werden konnten, waren: das KaossPad von Korg (vgl. das TouchPad der 2. Stunde!), TenoriOn von Yamaha (ein "sichtbarer" step-by-stepp-Sequenzer für Samples) und "Groove Boxes", deren erstes, analoges Exemplar "RaveOLution" die längst verschwundene Bastelfirma "Quasimidi" hergestellt hat:

Der heutige Stand der DJing-Tools (DJ-Controller) wird in der 11. Stunde vorgestellt.

Gehen Sie folgendermaßen vor:

Erster Durchgang = Erste Spalte lesen von oben nach unten. Welche Stichworte sagen mir etwas?

Zweiter Durchgang = Zweite Spalte (dazu) lesen. Was ist mir noch unklar?

Dritter Durchgang = Hören/Ansehen von zwei ausgewählten Titeln. Auswahl nach Interesse. Welche Bedeutung hat ein Komponist, ein Musiker, die Technik, die Elektronik und das Publikum? Stichworte ins leere Kästchen von Arbeitsblatt 10 schreiben!

* bedeutet, dass das Stück an anderer Selle des Seminars vorkommt, ** verweist auf "DOKUMENTE" auf Blatt 10.

Die folgenden Videos befinden sich auf der Youtube-Playlist "EM2020 Live-Elektronik".

| Stichwort | Erläuterung | Beispiele |

| Dialogprinzip | Ein Musiker interagiert improvisierend oder „nach Noten“ mit einem im Studio vorproduzierten Soundtrack („Fixed Media“). | Pierre Boulez „Dialogue“ 1985 |

| Klangverfremdung | Der Klang akustisch (live) gespielter Instrumente wird elektronisch verfremdet und/oder weiter verarbeitet (z.B. algorithmisch) | K. Stockhausen „Mikrophonie 1964“ e-beat: TamTam e-beat 2010 (Kommentar beachten) |

| DJing klassisch | Im Studio vorproduzierte „Grooves“ werden “ad hoc“ ( in Wechselwirkung mit dem Publikum) zusammengesetzt und (teilweise) verfremdet. | *Loveparade 1998: Marusha |

| DJing heute | Die Musikelektronikindustrie produziert viele Hilfen für eine „griffige“ Handhabung vorproduzierter Samples, Grooves oder Musikstücke. Hardware oder Software (z.B. Firmenvideo „Traktor“) | Impression: DJ-Abteilung des Music Store Köln 2020, Prototypische Geräte im Tonstudio der Uni OL (siehe auch 11. Stunde) |

| Elektro-Gruppen-improvisation | Auf elektronischen Instrumenten (kommerziell oder Selbstbau) wird in Gruppen frei bzw. nach Vorabsprachen improvisiert. | *Modularkonzert Berlin 2019 (siehe Stunde 7)

|

| Studioproduktion im Konzert nachgespielt | Wie in der Rockmusik üblich werden Musikstücke sowohl im Studio für CD als auch für einen Live-Auftritt „produziert“ (arrangiert). | *Jarre „Oxgene IV“: die CD wörtlich im Konzert nachgespielt. RTL 2012 |

| Algorithmisches Musizieren | Computerprogramme verbinden „Vorkomponiertes“ (einen Algorithmus) mit Möglichkeiten, das Vorkomponierte live zu beeinflussen. | *Algo-Demo (Stunde 2 und 7), |

| Gestural Controlled Music | Körpergesten oder -aktionen werden in elektronische Klänge verwandelt: (1) vollkommen frei (Avantgarde, Therapie, Musikpädagogik), (2) in eine (Computer-) Komposition integriert |

„Smart Textiles“ (pdf) und „Music-Wearables“, **STEIM: DJ Sniff, Crackle Synthi, PRP Voyager 2019 , Alex Nowitz |

| Drum-Pad-Prinzip | Berührungssensible Schlagflächen („Pads“) erzeugen MIDI-Daten: (1) „eins zu eins“ als elektronisches Schlagzeug, (2) algorithmisch verwandelt in andere musikalische Ereignisse eingebunden. |

(1) e-beat siehe Geräte z.B. im Ton- und Schlagzeugstudio der Uni OL, |

| Kaoss-Pad-Prinzip | Die Musikelektronikindustrie hat Geräte zum direkten Auslösen und Verfremden von Klangeffekten im Realtime-Verfahren produziert. | Beispiel: Firmenvideo, „Kaoss-Pad“ in e-beat 2010 (siehe oben) |

| Komplexere System | DJ-Techniken werden mit Elektro-Improvisation in einem „Orchester-Netz“ verknüpft. Rein analoge Klangerzeugung digital gesteuert. | TechnoMuseum 1997-2003:Technikerläuterung (Pptx), Home, Video (siehe unten). |

Projekt 1 "TechnoMuseum"

Das TechnoMuseum besteht aus 11 miteinander vernetzten Analogsynthesizern aus den 1970er Jahren, die von je einer Personm bedient werden.

Grundidee:

alle analogen Instrumente erhalten einen „Rhythmus“ in Gestalt eines komponierten Musters (Patterns) aus Triggerimpulsen – jedes Instrument einen eigenen, aber alles miteinander koordiniert,

die Instrumentalisten kreieren einen persönlichen Sound, der entweder „frei“ oder „getriggert“ ist, sie können also in den Groove ein- und aus ihm aussteigen.

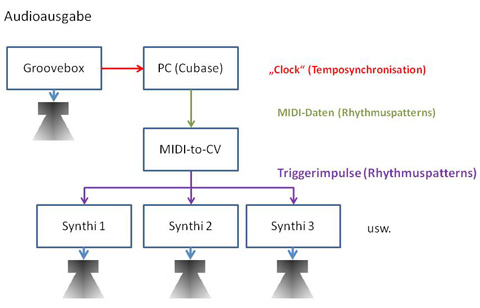

(1) Die Triggerimpulse für alle Analoggeräte werden durch ein „Technobrett“ eines Sequenzerprogramms (hier „Cubase“) erzeugt. Jedes Instrument „hat“ einen definierten MIDI-Kanal, sodass jeder Track im Technobrett einem Instrument zugeordnet ist.

(2) Das Technobrett (= mehrkanaliges Midifile) wird von einerr „Groovebox“ synchronisiert. Auf dieser Groovebox befindet sich zusätzliches musikalische Material, dass die akustische Basis der Aktivitäten der Analoginstrumente bildet: Rhythmuspatterns und Bassgroove. Das TechnoMuseum würde aber auch ohne diese Groovebox funktionieren. Die Grooves der Box könnten sich dann auch in Cubase befinden.

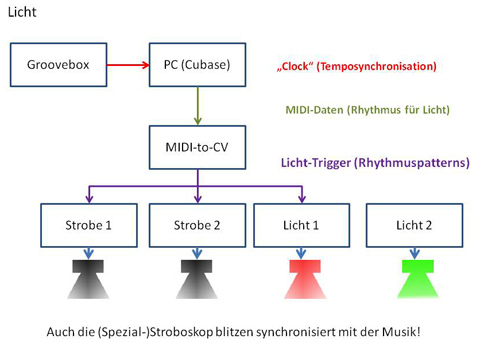

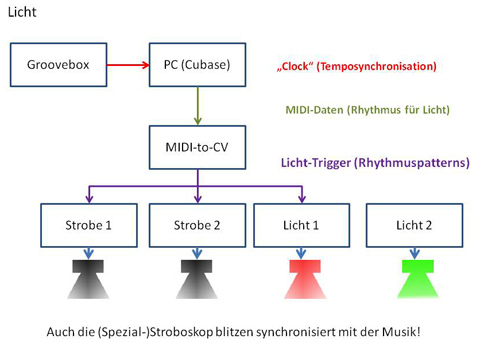

Analog zum Sound wird auch eine midifizierte Lichtanlage gesteuert. Im Sequenzerprogramm gibt es dazu eigene MIDI-Spuren.

Das folgende Video zeigt einige Bilder aus Proben und anschließend Spots aus einem Auftritt im Keller der Musikhochschule Köln:

Genaue Erläuterung der Technik und Durchführung auf einer extra PowerpointPrässentation Pptx-TechnoMuseum.

Projekt 2 "MIDI-Planetarium"

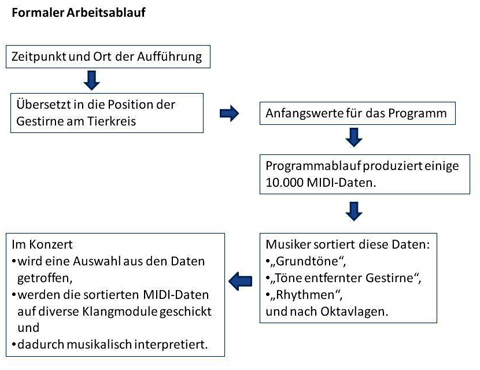

Das MIDI-Planetarium ist ein Computerprogramm, das aus gewissen Anfangswerten eine Abfolge von mehreren 10 Tausend MIDI-Daten innerhalb eines vorgegebenen Zeitraums produziert. Die improvisierenden Musiker/innen haben die Aufgabe, diesen Datenfluss im Konzert so auf verschiedene Soundmoduln zu lenken, dass sinnvolle Musik entsteht. Der "Sinn" der Musik ergibt sich aus den Anfangswerten und der Arbeitsweise des Programms: als Anfangswerte werden die Positionen von bis zu 15 Punkten entlang eines Kreises als Gestirne auf dem Tierkreis bzw. der Umlaufbahn von Planeten um die Sonne gedeutet; das Programm errechnet hieraus die MIDI-Daten im Sinne einer virtuellen Bewegung auf diesem Kreis. Im Grunde wird die Konstellation der Gestirne am Tierkreis (das sog. "Horoskop") musikalisch gescannt. Entfernungen werden in Ordnungszahlen von 32 Obertönen und die Frequenzen nach dem "kosmischen Gesetz der Oktav" von Hans Cousto errechnet.

Das MIDI-Planetarium setzt "Horoskope" vollkommen mechanisch in einen MIDI-Datenfluss um und ist insofern - wie viele algorithmische Programme - deterministisch. Die ausführenden Musiker/innen können die Komplexität dieser Datenproduktion bedingt durchschauen und im Live-Konzert erahnen, sie werden aber dennoch ständig von Ereignissen überrascht, auf die sie reagieren können. Sie können durch geschickte Klanggestaltung das Musikstück strukturieren, dabei nach Belieben auch astrologische Gesichtspunkte mit einfließen lassen oder aber nach rein musikalischen Gesichtspunkten vorgehen. Diese Doppelsinnigkeit ist in einem breit angelegten Forschungsprojekt untersucht worden, bei dem 55 Personen mit zumeist astrologischem Vorwissen eine "rein musikalisch" produzierte Version ihrer Geburtshoroskopvertonung nach strengen Vorgaben durcharbeiten mussten. Ihre Aussagen über Empfindungen und ähnliches beim Hören wurden den Ausgangsdaten zugeordnet und im Nachhinein festgestellt, inwiefern das Hören der Musik Wirkungen hervorgerufen hat, die mit astrologischen Aspekten des Horoskops korrespondierten. Näheres hierzu im einschlägigen Forschungsbericht.

Das am 1.7.1991 erstmals der Öffentlichkeit vorgeführte MIDI-Planetarium wurde innerhalb von 22 Jahren in 32 Konzerten "konzertant" aufgeführt und war Grundlage von fast 100 Kompositionsaufträgen. Es wurde 6 Stunden unter Wasser "in einer Klangnacht in Bad Sulza" ebenso vorgeführt wie zur Einweihung des Oldenburger Hörsaalgebäudes (siehe "Luftschiffe") oder als Installation im FMZ München, im Zeis Großplanetarium Berlin, im Planetarium von Brelemen und Osnabrück, im Freien und in normalen Konzertsälen. Bei den Konzerten dienten der Augenblick und die Koordinaten des Ort der Aufführung als Ausgangswerte. Besonders beliebt war die Kombination mit dem Obertonmuusiker Reinhard Schimmelpfeng, so am 1. Juli 2011, als das MIDI-Planetarium multimedial aufgeführt wurde, wobei die Bilder die jeweils in der Musik dominanten Planeten zeigen (siehe Programmheft). Hier dre vollständige Mitschnitt:

Das originale Video hat die Größe 1920x1080 Pixel und kann kostenlos erworben werden.

Weiter gehende Information auf der im BIS-Verlag Oldenburg erschienene Dokumentation.

Hausaufgabe (3 Möglichkeiten):

e-beat 2011 : Ordnen Sie das Gehörte/Gesehene - soweit erkennbar - den Kategorien von Blatt 10 zu (welche Geräte, welche Effekte? mit Minuten/Sekunden-Angabe)! URL explizit: https://www.youtube.com/watch?v=X-MW4FBWb-k

Analysieren Sie das Marusha-Video(Youtube-Link) aus der LoveParade 1998 unter den Aspekten: „Strategie“, musikalische Mittel und Wirkung! (Vorgehen analog „Spoon/van Dyk“ im Seminar.)

Die vier STEIM-Videos sind dem Feature „A Critical History of Media Art in the Netherlands Part 1: STEIM“ entnommen (Dauer 90 Minuten). Entnehmen Sie diesem Video die Erläuterungen zu den vier Ausschnitten STEIM: DJ Sniff, Crackle Synthi, PRP Voyager 2019 , Alex Nowitz. URL explizit: https://www.youtube.com/watch?v=9mXg8rtR3s4